Con la A100, Nvidia presenta la primera GPU con arquitectura Ampere. Se dice que el enorme chip de 7nm no sólo es significativamente más potente, sino también mucho más flexible que su predecesor Volta. Con DGX A100, HGX A100 y EGX A100, hay plataformas para centros de datos y edge computing.

El epónimo de la arquitectura Ampere de Nvida es el físico y matemático francés André-Marie Ampère, que da nombre a la unidad de amperaje Ampere. El nombre encaja, porque el procesador Ampere A100 de Nvidia es, con diferencia, la GPU más potente jamás fabricada. En algunas aplicaciones, se dice que es hasta 20 veces más rápido que su predecesor Volta, según Jensen Huang, fundador y CEO de Nvidia.

En la frontera de la tecnología de 7nm

A diferencia de su predecesor V100 con arquitectura Volta, el A100 ya no se fabrica en TSMC en 12 nm, sino en 7 nm. Con una superficie de 826 mm², el chip Ampere es, sin embargo, más grande. El número de transistores ha aumentado de 21.100 millones a 54.000 millones en comparación con el V100. Esto sitúa al chip en el límite de lo que es factible con 7 nm, según Huang.

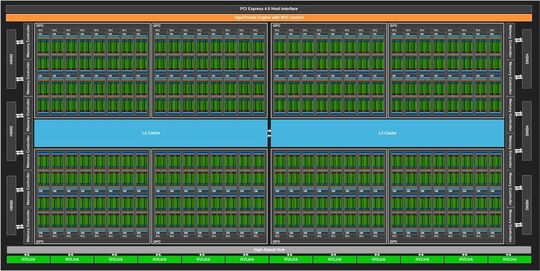

El A100, como primera implementación de la arquitectura de hardware GA100 con, en principio, hasta 128 multiprocesadores(SM) de streaming, tiene 108 SMs activos. Estos se dividen en 3.456 núcleos FP64 y 6.912 núcleos FP32. Aunque el número de núcleos FP64 y FP32 ha aumentado considerablemente en comparación con el GV100, Nvidia ha reducido el número de núcleos tensoriales de 640 a 432. Sin embargo, se dice que estos Tensor Cores de tercera generación son significativamente más potentes, especialmente para aplicaciones de IA, porque pueden manejar Tensor Float 32 (TF32), un nuevo formato de punto flotante que combina el rango de datos de FP32 y la precisión de FP16. En comparación con Volta, se supone que Ampere es más rápido por un factor de 20 en el entrenamiento de IA con baja precisión. La escasez es un enfoque relativamente nuevo para optimizar las redes neuronales profundas. Con la arquitectura GA100, Nvidia introduce la aceleración de sparsity estructural: nuevas instrucciones Sparse Tensor Core que duplican el rendimiento de las operaciones de matrices dispersas con formatos TF32, FP16, BFLOAT16, INT8 e INT4. Además, las cargas de trabajo se distribuirán mejor entre los distintos nodos.

Además, los Tensor Cores aceleran el FP64 para aplicaciones HPC. Así, según Nvidia, un A100 realiza 19,5 TFOPS frente a los 7,8 TFLOPS del chip V100.

La caché de nivel 2 del A100 es de 40 MB, 6,7 veces mayor que la del V100 y está dividida en dos particiones para aumentar el ancho de banda y reducir la latencia.

En el paquete de la GPU hay 40 GB de memoria rápida HBM2 en forma de cinco pilas con ocho troqueles de memoria por pila. Nvidia afirma que el ancho de banda de la memoria es de 1.555 GB/s, 1,7 veces más que Volta. El módulo SXM4 con la GPU A100 es ahora compatible con PCI Express 4.0, y NVLink 3.0 se utiliza para comunicar varios chips A-100, el doble de rápido que NVLink 2.0 a 600 GB/s.

El soporte de la API para las innovaciones de Ampere se incluye en Cuda 11. Además, Nvidia ofrece contenedores optimizados para la GPU para aplicaciones de deep learning, machine learning y HPC que ya incluyen el kit de herramientas Cuda 11. Son sólo una parte de la pila completa de software, que también incluye modelos preformados.

Hasta siete GPUs en una

Para flexibilizar los sistemas con GPUs A100, la nueva función GPU Multi-Instancia (MIG) permite dividir cada GPU en hasta siete instancias de GPU independientes, cada una de ellas diseñada para ofrecer el rendimiento de una V100 para aplicaciones específicas. Cada instancia tiene sus propias rutas en el sistema de memoria completo. Con MIG, las máquinas virtuales individuales o los contenedores pueden utilizar las instancias de forma aislada y con una calidad de servicio definida. Esto es especialmente importante para los proveedores de servicios. En un sistema DGX-A100 o un sistema OEM con ocho GPUs cada uno, MIG también puede activarse selectivamente en GPUs individuales.

Sistemas de computación para el centro de datos

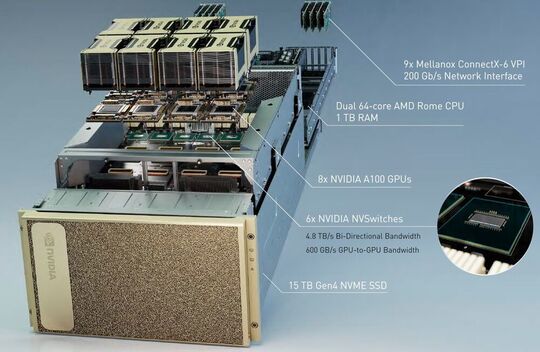

Nvidia no ofrece la GPU A100 para su uso en el centro de datos como una tarjeta enchufable, sino sólo como un sistema completo DGX-A100 o como placas equipadas con varias GPU para los fabricantes OEM. La DGX A100 es ya la tercera generación DGX de Nvidia. Según el fabricante, el sistema es el primer servidor de 5-petaFLOPS del mundo. Huang, CEO de Nvidia, explica que un centro de datos con cinco sistemas DGX-A100 para el entrenamiento y la inferencia de la IA tiene aproximadamente el mismo rendimiento que un centro de datos anterior con 50 sistemas DGX-1 para el entrenamiento y servidores adicionales con unas 600 CPU para el resto de las tareas. Los cinco servidores DGX-A100 requieren 28 KW y cuestan alrededor de un millón de dólares, mientras que el anterior centro de datos costaba más de 11 millones con un consumo de energía de 630 KW. Para requisitos extremos, Nvidia ofrece un DGX SuperPOD con 140 sistemas DGX-A100 y 700 PetaFLOPS. Los sistemas individuales están conectados por componentes de red de Mellanox. Nvidia ha adquirido recientemente Mellanox.

En un solo sistema DGX-A100 en formato 4U, hay ocho GPU A100 interconectadas por seis NVSwitches a través de NVLink 3.0. Se asientan en una placa base con dos procesadores AMD Epyc 7742 actuales de la generación Rome con 64 núcleos cada uno. Intel, el proveedor de procesadores de los anteriores sistemas DGX, aún no tiene ningún procesador con soporte PCI Express 4.0 en su cartera. Esto solo llegará con Ice Lake SP a finales de este año.

La memoria principal de la placa base es de un TB, el almacenamiento masivo consiste en SSDs PCIe 4.0 con 15 TB de capacidad total. La conectividad de red la proporcionan ocho Mellanox ConnectX-6 VPI de un solo puerto para HDR Infiniband de 200 Gb/s y un ConnectX-6 VPI de dos puertos para Ethernet de 200 Gb/s.

Para los proveedores de la nube que tienen sus propios servidores montados o para los fabricantes OEM, Nvidia ofrece dos placas base HGX-A100 diferentes. La variante grande está equipada con ocho GPU y está diseñada para sistemas con dos CPU, mientras que la pequeña, con cuatro, está pensada para sistemas de una sola CPU. La conexión a las placas base con CPU y RAM se establece a través de PCI Express en cada caso.

Según Nvidia, los sistemas con HGX A100 provendrán de los fabricantes Atos, Cray, Dell, Fujitsu, Gigabyte, HPE, Inspur, Lenovo, QCT y Supermicro. Nvidia nombra a Alibaba, AWS, Baidu, Google, Microsoft Azure, Oracle así como Tencent como proveedores de la nube con sistemas A100.

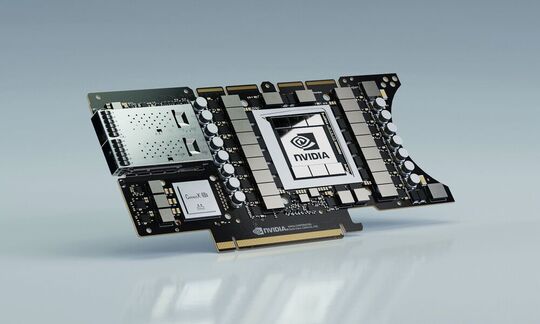

Ampliar la computación de borde

Para aplicaciones en el borde de la red, Nvidia incorpora la tarjeta plug-in EGX A100 PCIe con una GPU A100 y un Mellanox ConnectX-6 DX para Ethernet de 100Gb/s o Infiniband. Nvidia nombra como áreas de aplicación las ciudades inteligentes, la medicina, la infraestructura 5G, el reconocimiento de voz, la robótica y la conducción autónoma. Nvidia ofrece marcos de aplicación para todos estos sectores. Mientras que los sistemas DGX-A100 ya están en manos de los clientes, las tarjetas EGX-A100 deberían estar disponibles a finales de año.